آموزش بهینهسازی فایل Robots.txt وردپرس برای موتورهای جستجو

کاربران و مدیران وبسایت های وردپرسی به دنبال راه مختلفی هستند تا به وسیله بهینه سازی موارد مختلف ورردپرس، همانند فایل robots.txt ، سئو وبسایت خود را بهبود ببخشند فایل robots.txt به موتورهای جستجو نحوه خزیدن در وبسایت شما را گفته و به همین جهت یک ابزار قدرتمند جستجوگر است. در این مقاله ما به شما نحوه ایجاد یک فایل robots.txt کامل برای SEO را نشان خواهیم داد.

فایل robots.txt چیست؟

Robots.txt یک فایل متنی میباشد که صاحبان وب سایتها به وسیله آن می توانند بگویند که موتورهای جستجوگر چگونه به خزیدن و فهرست صفحات در سایت خود بپردازند.

این فایل معمولا در دایرکتوری ریشه اصلی وبسایت ذخیره می شود که به عنوان پوشه اصلی وب سایت شما شناخته می شود. فرمت اصلی فایل یک فایل robots.txt به صورت زیر است:

User-agent: [user-agent name] Disallow: [URL string not to be crawled] User-agent: [user-agent name] Allow: [URL string to be crawled] Sitemap: [URL of your XML Sitemap]

شما می توانید خطوط مختلفی از دستورالعمل ها برای اجازه دادن یا رد URL های خاص و اضافه کردن چند نقشه سایت اضافه کنید. اگر نشانی اینترنتی را رد نکنید، موتورهای جستجوگر موتور جستجو فرض می کنند که مجاز به ردیابی آن هستند.

در اینجا فایل نمونه مثال robots.txt می تواند مشاهده کنید:

User-Agent: * Allow: /wp-content/uploads/ Disallow: /wp-content/plugins/ Disallow: /wp-admin/ Sitemap: https://example.com/sitemap_index.xml

در مثال بالا robots.txt ، ما موتورهای جستجو را مجبور کرده ایم تا فایل ها موجود در پوشه آپلود وردپرس را رها کند.

پس از آن، ما رباتهای موتورهای جستجو را از خزیدن در پوشه های پوستهها، افزونهها و مدیریت وردپرس منع کردهایم.

و در نهایت ما آدرس نقشه سایت خود را قرار داده ایم.

آیا شما نیاز به یک فایل Robots.txt برای سایت وردپرس خود دارید؟

اگر فایل robots.txt ندارید، با این حال باز هم موتورهای جستجو همچنان وب سایت شما را بررسی خواهند کرد. با این حال، شما قادر نخواهید بود به موتورهای جستجو بگویید که کدام صفحات یا پوشه ها را نباید بررسی کنید.

البته این برای زمانی که شما یک وبلاگ ساده داشته تازه آن را راه اندازی کرده اید تاثیری نخواهد گذاشت.

با این حال به عنوان وب سایتی که در حال رشد است و احتملا شما مقدار زیادی از مطالب را دارید، احتمالا می خواهید کنترل بیشتری بر روی چگونگی خیزش و نمایه سازی وب سایت خود داشته باشید.

در اینجا دلایلی برای استفاده از فایل Robots.txt وجود دارد!

- هر وبسایت دارای سهمیه مشخصی از خزنده های موتورهای جستجو میباشند!

این به این معنی است که آنها یک تعداد مشخصی از صفحات را در طول یک جلسه بررسی می کنند. این باعث میشود تا مراحل خزیدن موتورهای جستجو با زمان بیشتری انجام شده و دیرتر به نتایج مورد نظر دست پیدا کنید.

با عدم رها کردن صفحات غیر ضروری، روند ایندکس شدن صفحات طولانی خواهد شد!

شما می توانید این مورد را با اجازه دادن به ربات های جستجو ، برای رها کردن صفحات غیر ضروری مانند صفحات مدیریت وردپرس خود، فایل های افزونه و پوشه تم ها را رفع کنید.

با غیر فعال کردن صفحات غیر ضروری، سهمیه خزنده های مورتوهای جستجوی در وبسایت خود را ذخیره کنید. این به موتورهای جستجو کمک می کند تا صفحات بیشتری را در وبسایت شما را بررسی کرده و نتایج بهتری را کسب کنید.

دلیل دیگری برای استفاده از فایل robots.txt زمانی است که شما می خواهید موتورهای جستجو را از بررسی یک پست یا صفحه در وب سایت خود منع کنید.

این امن ترین راه برای مخفی کردن مطالب از افراد غیرمجاز نیست، اما به شما کمک می کند تا از قرار گرفتن در نتایج موتورهای جستجو جلوگیری کنید.

چگونه یک فایل Robots.txt ایده آل داشته باشد؟

بسیاری از وبلاگ های محبوب از یک فایل robots.txt بسیار ساده استفاده می کنند. محتوای آنها ممکن است بسته به نیازهای سایت خاص متفاوت باشد.

User-agent: * Disallow: Sitemap: http://www.example.com/post-sitemap.xml Sitemap: http://www.example.com/page-sitemap.xml

این فایل robots.txt اجازه می دهد تمام خزنده ها و ربات ها به فهرست همه محتوا و لینک آنها را به نقشه های XML وب سایت دسترسی داشته باشد.

برای سایت های وردپرس،درج قوانین زیر را در فایل robots.txt توصیه می کنیم:

User-Agent: * Allow: /wp-content/uploads/ Disallow: /wp-content/plugins/ Disallow: /wp-admin/ Disallow: /readme.html Disallow: /refer/ Sitemap: http://www.example.com/post-sitemap.xml Sitemap: http://www.example.com/page-sitemap.xml

این کدها به ربات های موتورهای جستجو برای نشان دادن تمام تصاویر و فایل های وردپرس پیشنهاد می کند. همچنین ربات های جستجو از بررسی فایل های افزونه های وردپرس، مدیریت وردپرس، فایل readme وردپرس و لینک های وابسته ، منع خواهد کرد.

با اضافه کردن نقشه های سایت به فایل robots.txt، کار را برای ربات های گوگل برای پیدا کردن همه صفحات در سایت خود آسان می کنید.

حالا شما می دانید که یک فایل robots.txt ایده آل و کاربردی به نظر می رسد، اجازه دهید نگاهی به چگونگی ایجاد یک فایل robots.txt در وردپرس کنیم.

آموزش ایجاد فایل robots.txt در وردپرس

دو راه برای ایجاد یک فایل robots.txt در وردپرس وجود دارد. شما می توانید روش هایی را که برای شما مناسب است، انتخاب کنید.

روش 1: ویرایش فایل Robots.txt با استفاده از افزونه Yoast SEO

اگر از افزونه Yoast SEO استفاده می کنید، میتوانید با این فایل کار کنید.

شما می توانید از آن برای ایجاد و ویرایش فایل robots.txt به طور مستقیم از مدیریت مدیریت وردپرس خود استفاده کنید.

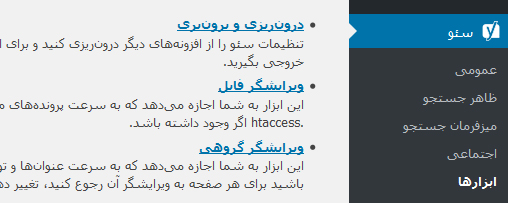

به سادگی به منو سئو » ابزارها در مدیریت وردپرس خود بروید و روی لینک ویرایشگر فایل کلیک کنید.

در صفحه بعدی، افزونه یوئست سئو ، فایل robots.txt موجود شما را نشان می دهد.

اگر شما یک فایل robots.txt ندارید، افزونه yoast seo فایل robots.txt را برای شما ایجاد خواهد کرد.

به طور پیش فرض، ایجاد کننده فایل robots.txt در افزونه yoast seo قوانین زیر را به فایل robots.txt اضافه می کند:

User-agent: * Disallow: /

مهم است که این متن را حذف کنید زیرا تمام موتورهای جستجو را از خزیدن در وب سایت شما متوقف خواهد کرد.

پس از حذف کدهای پیش فرض، میتوانید از قوانین دلخواه خود جهت افزودن به این فایل استفاده کنید. توصیه میشود از کدهای بهینه شده در همین پست که مطالعه کردید ، استفاده کنید.

روش 2.ایجاد فایل robots.txt به صورت دستی با استفاده از ftp و هاست خود

در این روش تنها نیاز است که به مدیریت هاست خود وارد شده و در ریشه اصلی وبسایت خود این فایل را به نام robots.txt ایجاد کنید. همچنین اگر این فایل از قبل وجود دارد دیگر نیازی به ایجاد آن نیست و تنها میتوانید با ویرایش آن، قوانین جدید خود را به آن اضافه کنید.

برای این منظور میتوانید از کدهای بهینه شده این فایل که در این پست مطالعه شد، استفاده کنید.

روش تست فایل robots.txt

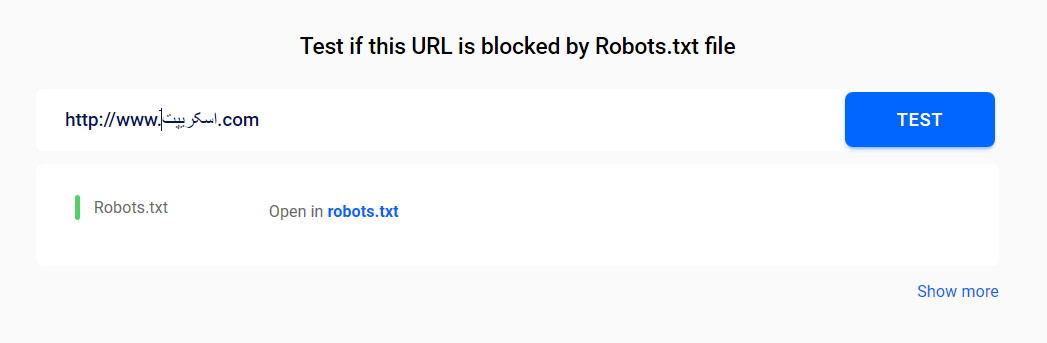

پس از ایجاد و افزودن کدهای خود به فایل robots.txt بهتر است که آن را تست کرده تا از عملکرد مطلوب آن آگاه شوید.

ابزارهای تست robots.txt بسیاری وجود دارد، به وسیله آن میتوانید این فایل را بررسی کنید. برای این منظور میتوانید از ابزار sitechecker استفاده کنید. با ورود به این سایت میتوانید آدرس وبسایت خود را وارد کرده تا این وبسایت به صورت کامل این فایل را بررسی کند.

سخن پایانی

هدف بهینه سازی فایل robots.txt شما این است که موتورهای جستجو را از صفحات خالی که در دسترس عموم قرار ندارند منع کنند. برای مثال، صفحات در پوشه wp-plugins یا صفحات شما در پوشه مدیریت وردپرس .

یک باور اشتباه و رایج در بین کارشناسان این است که مسدود کردن دسته بندی های وردپرس، تگ ها و صفحات بایگانی باعث بهبود سرعت خزیدن و منجر به بررسی سریع و رتبه بندی بالاتر خواهد شد.

البته این باور اشتباهی بوده و به هیچ عنوان توصیه نخواهد شد و شما نباید از این روش استفاده کنید.

در این پست کدهای بهینه شده این فایل را نیز در اختیارتان قرار دادیم که میتوانید از آن ها استفاده کنید.